Bis in die 1970er Jahre hinein galt der Western als das bedeutendste Genre der US-amerikanischen Filmindustrie. Besonders die 1940er und 1950er Jahre markieren die Hochphase des klassischen Westerns, mit ikonischen Helden, epischen Landschaften und klaren moralischen Fronten. Doch im 21. Jahrhundert…

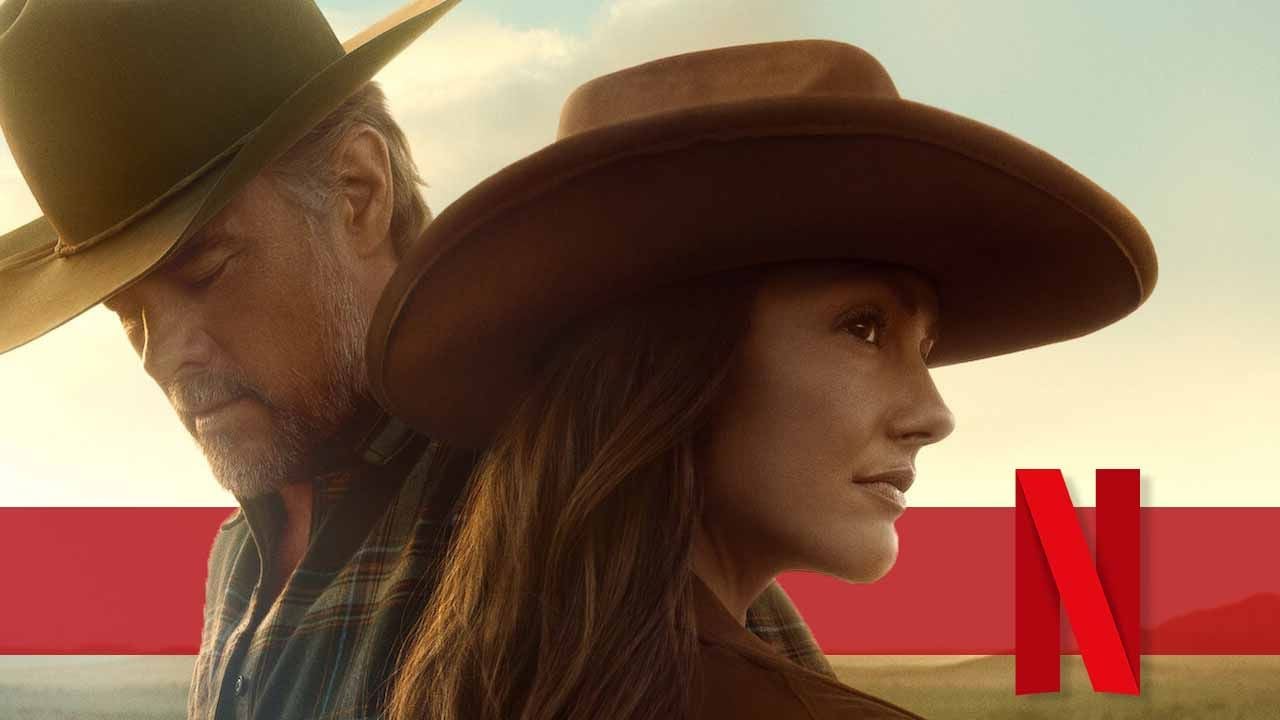

Neu auf Netflix: Western-Serien-Nachschub für alle "Yellowstone"-Fans

1 day ago

1 day ago